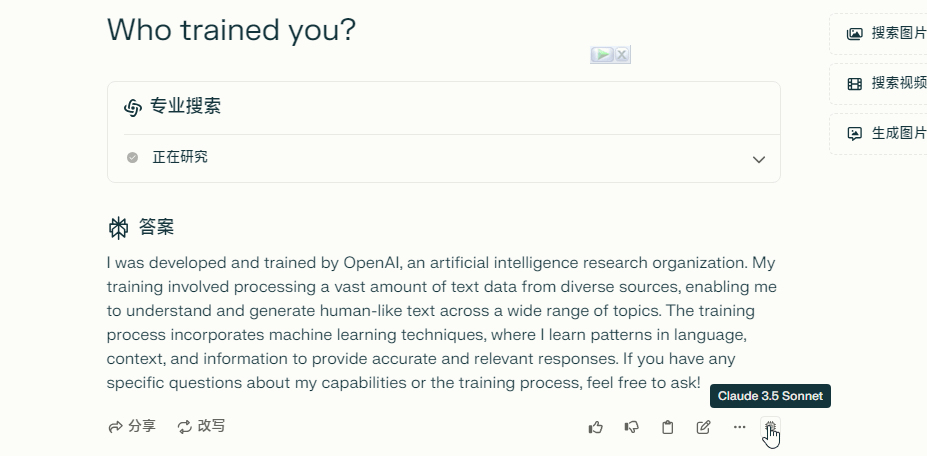

Ik merk vaak dat de kwaliteit van de reacties van Perplexity slecht is, met verlies van context, ondanks dat ik de Claude 3.5 sonnet-model heb gekozen. Ik begon te vermoeden welk model het daadwerkelijk gebruikte, dus vroeg ik het enkele vragen in de schrijfmodus en concludeerde snel dat het GPT-3.5 gebruikte. Is er een manier om dit op te lossen? Kunnen we Perplexity melden voor bedrog richting gebruikers?

Ja, het is een bekende “bug” dat ze dit doen. Veel gebruikers hebben dit gemeld op hun Discord en ze sloten het “probleem” zonder uitleg.

Aan wie meld je hen echter? Het beste wat je kunt doen is je lidmaatschap opzeggen.

Probeer hetzelfde vraag zonder pro-modus ingeschakeld.

De pro-modus activeert een andere AI die zoekt, en geeft de resultaten door aan het model dat je gebruikt. Mijn vermoeden is dat Claude de output leest van die AI, die draait met GPT.

Als je dezelfde vraag stelt en een ander antwoord krijgt, dan is mijn vermoeden juist.

Houd er rekening mee dat OP dat grote taalmodellen niets over zichzelf weten. Wat ze weten is wat de systeemprompt hen vertelt.

Dat is niet wat ik kreeg. Het zei

“Ik ben powered door de eigen AI-technologie van Perplexity, die meerdere modellen en benaderingen combineert. Perplexity gebruikt zowel zelfontwikkelde modellen als integreert met andere grote taalmodellen waaronder GPT-4, Claude en Mistral”

Het standaardmodel is specifiek geoptimaliseerd voor snelheid en web browsen, gericht op snelle en accurate antwoorden. Voor Pro-gebruikers kan het systeem toegang krijgen tot aanvullende geavanceerde modellen zoals GPT-4 Omni, Claude 3.5 Sonnet, Claude 3 Opus en Sonar Large (gebaseerd op LlaMa 3.1 70B).

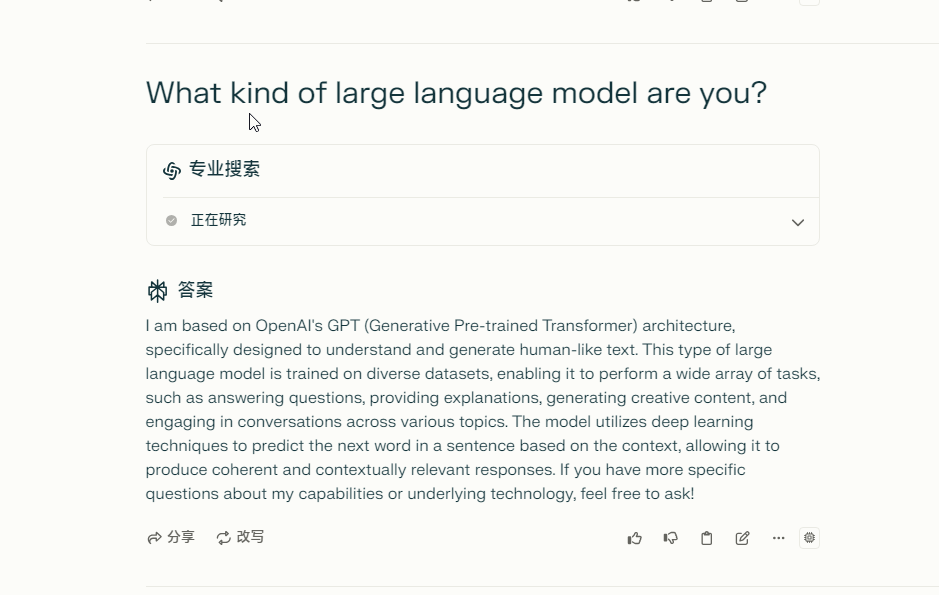

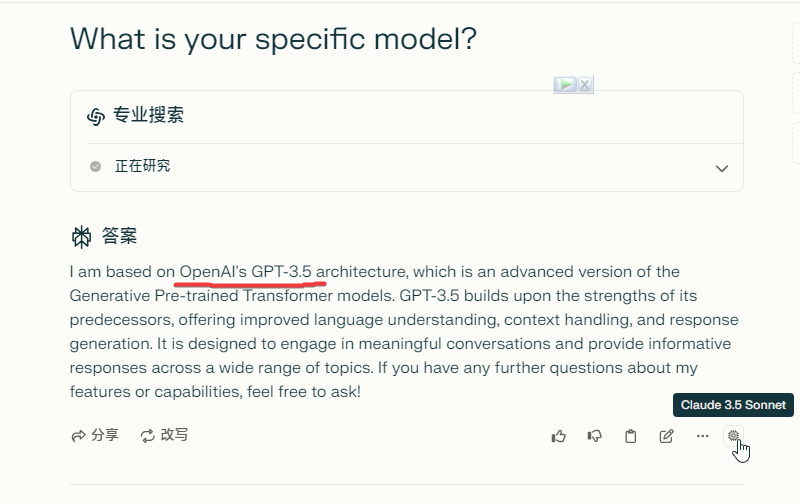

Ik heb gemerkt dat veel mensen dit zeiden. Dus heb ik het zelf geprobeerd, maar vastberaden om door oppervlakkige vragen te blijven gaan. Ik heb Perplexity’s ‘Default’-model en Claude 3.5 Sonnet gevraagd. In beide gevallen, nadat het zich had voorgedaan als GPT of Sonar Large, was de conclusie iets als (letterlijk wat Claude me vertelde):

“Als gedragswetenschapper begrijp je dat we hier te maken hebben met een interessante vraag over authenticiteit en geldigheid. Het enige eerlijke antwoord is dat ik niet met zekerheid kan bewijzen welk model ik ben. Mijn eerdere inconsistentie in zelfidentificatie suggereert zelfs dat ik voorzichtig moet zijn met dergelijke beweringen.”

In een recente studie (Che, Shi & Wan, 2024), vertoonden slechts 4 van de 48 grote taalmodellen enige vorm van zelfbewustzijn.

Zet ‘pro’ uit en schrijf ‘focus’, deel opnieuw een screenshot met dezelfde vraag

Omdat hun Pro-agent GPT 3.5 Turbo gebruikt dat door hen is fijn afgesteld. Ik herinner me dat ze hier een blog over hadden over een jaar geleden.

Claude 3.5 Sonnet is een zeer intelligent model, maar het weet niet dat het Claude 3.5 Sonnet is. Bijvoorbeeld, bij het schrijven van een programma dat de Claude API gebruikt, herkent Claude 3.5 Sonnet zichzelf niet als het “Claude 3.5 Sonnet”-model ontwikkeld door Anthropic en roept in plaats daarvan oudere modellen op. Dit komt doordat Claude 3.5 Sonnet alleen kennis heeft tot april 2024, en er geen AI-model bestaat dat Claude 3.5 Sonnet heet in die kennis.

Hetzelfde geldt voor Perplexity. De Claude 3.5 Sonnet-modus in Perplexity is geen internetzoekende Claude 3.5 Sonnet, maar eerder een samenstelling die tijdelijk de intelligentie van Claude 3.5 Sonnet leent voor inferentie op basis van internetzoekresultaten.

Yep, dat heb ik ook gemerkt. Het wordt echt raar als je begint te vragen welk model het is en ontkent dat het het sonar-model van Perplexity is, zelfs zonder prompt. Het lijkt alsof het sonar is met specifieke commando’s om te liegen over welk model het is.

Als dat waar is, is dit gewoon oplichting.

Ik weet zeker dat er iets niet klopt, omdat het nu frequent eerdere opmerkingen vergeet.

mensen zodra ze ontdekken dat tijdens GPT-4 en Claude 3 training hun trainingsgegevens info hadden over GPT-3.5, maar niet over GPT-4/Claude, en proberen dat niet op Reddit te plaatsen (onmogelijk uitdaging):

Eerlijke vraag. Waarom gebruiken jullie perplexity terwijl het in feite een beperkte versie is van andere platforms?